Java大数据处理Hadoop与Spark应用?如何实现高效数据处理

![]() 游客

2025-04-21 21:34:01

1

游客

2025-04-21 21:34:01

1

在当前的大数据时代,企业和研究机构都在寻求高效处理海量数据的方法,以驱动业务洞察和科学研究。Java作为一门广泛使用的编程语言,在大数据处理领域同样扮演着重要角色。特别是与Hadoop和Spark这两大框架的结合,让Java在处理大数据方面展现出了极大的优势。本文将深入探讨如何通过Java结合Hadoop与Spark实现高效的数据处理,并提供实操步骤和技巧,帮助读者全面掌握这一技术。

Java大数据处理的背景与必要性

在谈论如何使用Java进行大数据处理之前,我们有必要先了解为何选择Java作为大数据处理的编程语言。Java具有跨平台、对象导向、安全性高以及拥有大量库和框架支持等优点。这些特性让Java成为企业级应用开发的首选语言,也使其在大数据处理领域具有先天优势。随着Hadoop和Spark等大数据框架的兴起,Java在大数据领域的应用更加广泛。

Java与Hadoop的结合

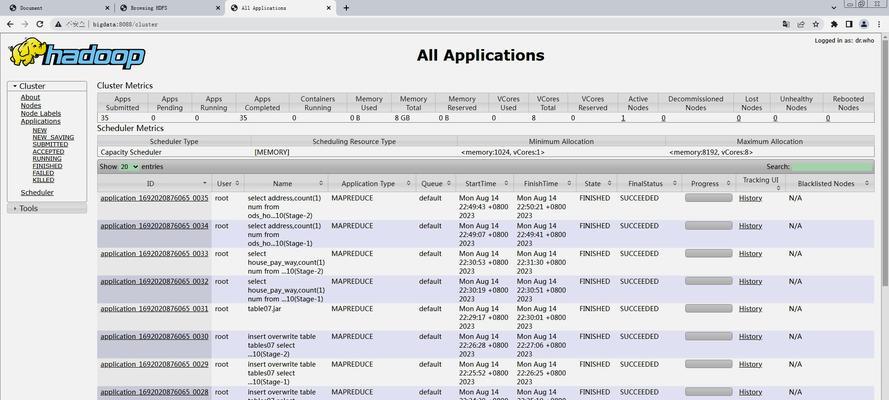

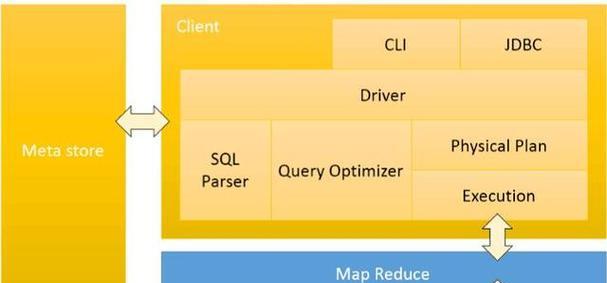

Hadoop是一个由Apache基金会开发的开源框架,它允许使用简单的编程模型在大量分布式计算机上进行存储和处理大数据集。Hadoop主要由两个核心组件构成:Hadoop分布式文件系统(HDFS)和MapReduce。

Hadoop分布式文件系统(HDFS)

HDFS是一个高度容错的系统,适合在廉价硬件上运行。它提供了高吞吐量的数据访问,非常适合大规模数据集的应用。Java通过其标准库和第三方库,可以很容易地与HDFS进行交互,进行数据的读写操作。

MapReduce

MapReduce是一种编程模型,用于在Hadoop集群上并行处理大量数据。Java提供了MapReduce的完整支持,开发者可以使用Java编写Map和Reduce任务,以实现复杂的数据处理逻辑。

Java与Spark的结合

Spark是一个开源的快速大数据处理框架。相比于HadoopMapReduce,Spark能够在内存中处理数据,因此在很多场景下速度要快得多。Spark同样支持Java,这使得Java开发者能够利用Spark的内存计算能力。

Spark的优势

Spark的核心是弹性分布式数据集(RDD),它是一个容错的、并行操作的数据结构,可以让用户显式地将数据存储在内存中,从而进行多次运算。Java通过其API可以很方便地操作RDD,从而实现高效的计算。

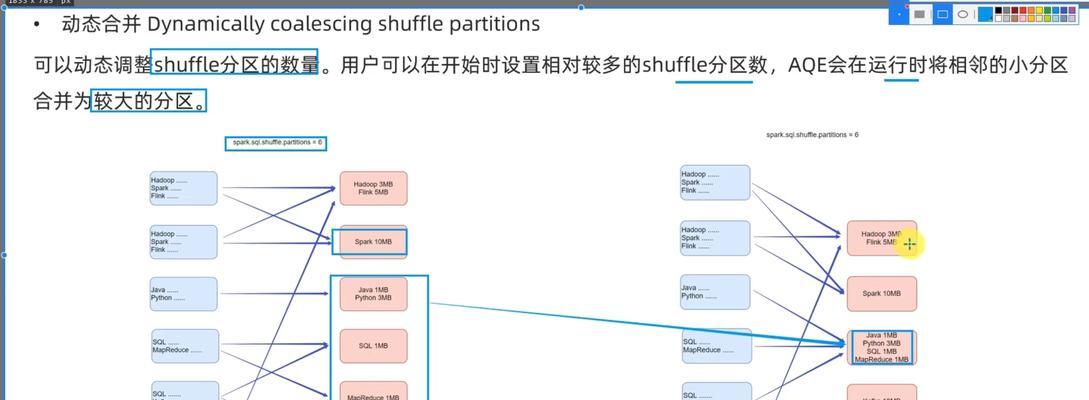

Spark的生态系统

Spark不仅仅是一个简单的处理框架,它还拥有一系列的生态系统组件,包括SparkSQL用于处理结构化数据,MLlib用于机器学习,GraphX用于图计算等。Java开发者可以利用这些组件,来应对多样化的数据处理需求。

如何通过Java实现高效的数据处理

实操步骤:Hadoop

第一步:环境搭建

确保你已经安装了Java开发环境和Hadoop。然后设置环境变量,使得Java和Hadoop可以被命令行正确调用。

```bash

exportJAVA_HOME=/path/to/java/home

exportPATH=$JAVA_HOME/bin:$PATH

exportHADOOP_HOME=/path/to/hadoop

exportPATH=$HADOOP_HOME/bin:$PATH:$HADOOP_HOME/sbin

```

第二步:编写MapReduce程序

使用Java编写MapReduce程序,你需要定义Map函数和Reduce函数。下面是一个简单的例子:

```java

publicclassWordCount{

publicstaticclassTokenizerMapperextendsMapper

privatefinalstaticIntWritableone=newIntWritable(1);

privateTextword=newText();

publicvoidmap(Objectkey,Textvalue,Contextcontext)throwsIOException,InterruptedException{

StringTokenizeritr=newStringTokenizer(value.toString());

while(itr.hasMoreTokens()){

word.set(itr.nextToken());

context.write(word,one);

publicstaticclassIntSumReducerextendsReducer

privateIntWritableresult=newIntWritable();

publicvoidreduce(Textkey,Iterable

intsum=0;

for(IntWritableval:values){

sum+=val.get();

result.set(sum);

context.write(key,result);

//Mainmethodanddrivercode

```

第三步:运行你的程序

将编写好的Java程序打包成jar文件,然后使用Hadoop命令行提交你的MapReduce作业:

```bash

hadoopjarwordcount.jarWordCount/input/output

```

实操步骤:Spark

第一步:环境搭建

安装Java开发环境,并下载Spark。配置SPARK_HOME环境变量,以及将Spark的bin目录加入PATH。

```bash

exportSPARK_HOME=/path/to/spark

exportPATH=$PATH:$SPARK_HOME/bin:$SPARK_HOME/sbin

```

第二步:编写Spark程序

使用Java编写Spark程序,你需要定义SparkContext,然后通过它来创建RDD,并进行操作。以下是一个使用Java编写的简单SparkWordCount程序:

```java

importorg.apache.spark.*;

importorg.apache.spark.api.java.*;

importorg.apache.spark.api.java.function.*;

publicclassJavaWordCount{

publicstaticvoidmain(String[]args)throwsException{

SparkConfconf=newSparkConf().setAppName("JavaWordCount");

JavaSparkContextsc=newJavaSparkContext(conf);

JavaRDD

JavaRDD

JavaPairRDD

JavaPairRDD

wordCount.saveAsTextFile("hdfs://path/to/output");

```

第三步:运行你的Spark程序

同样地,编译Java程序为jar文件,并使用spark-submit命令运行:

```bash

spark-submit--classJavaWordCountyour-spark-application.jar

```

常见问题与解决方案

Hadoop

问题1:在运行HadoopMapReduce程序时出现内存不足的问题。

解决方案:调整map和reduce任务的内存配置。可以通过修改mapred-site.xml文件,设置mapreduce.map.memory.mb和mapreduce.reduce.memory.mb的值来调整。

问题2:如何优化Hadoop集群性能?

解决方案:优化Hadoop集群性能通常包括合理配置集群硬件资源、优化HDFS块大小、配置合理的副本数量、使用YARN进行资源管理等。

Spark

问题1:Spark程序在运行时内存不足。

解决方案:在Java中,可以通过设置spark.executor.memory属性来配置执行器的内存大小。同时,可以通过动态资源分配和内存管理优化来改善性能。

问题2:如何处理大数据集导致的性能瓶颈?

解决方案:使用Spark的持久化功能(cache/persist)来存储中间数据,或者针对特定操作使用广播变量(broadcastvariables)来提高效率。

结语

通过以上的介绍和实践,我们可以看到Java在结合Hadoop和Spark后,能够为数据处理带来强大的能力。无论是需要处理大规模结构化数据的HadoopMapReduce,还是追求高性能处理的Spark,Java都提供了一套完善的解决方案。通过不断优化和实践,开发者可以高效地解决复杂的大数据问题。掌握这些技术,将有助于你在大数据时代中保持竞争力。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 3561739510@qq.com 举报,一经查实,本站将立刻删除。

转载请注明来自九九seo,本文标题:《Java大数据处理Hadoop与Spark应用?如何实现高效数据处理》

标签:Java

- 搜索

- 最新文章

- 热门文章

-

- 百度网站优化排名如何提升?有效策略是什么?

- 长尾关键词是什么意思?如何利用长尾关键词提升SEO效果?

- 网站排名优化的原理是什么?如何通过基础知识进行优化?

- 网站优化方案怎么制定?常见问题有哪些解决方法?

- 网站建设深圳有哪些优势?如何选择深圳网站建设服务?

- SEO优化的核心是什么?如何有效提升网站排名?

- 企业SEO优化排名要怎样提升?提升策略和常见问题解答?

- 北京seo优化外包服务有哪些优势?如何选择合适的外包公司?

- 龙口网站制作流程是怎样的?

- SEO关键词如何优化?掌握这些技巧提升网站排名!

- SEO网站优化排名的要求是什么?如何满足这些要求以提升网站排名?

- 做网站设计时应该注意哪些细节?

- 网站手机版排名seo怎么做?有哪些优化策略?

- 建设网站制作需要考虑哪些因素?

- 网站优化步骤有哪些?如何一步步提升网站SEO效果?

- 网站关键词的选择和优化方法是什么?

- SEO优化收费标准是什么?如何避免额外费用?

- SEO优化的标准流程是怎样的?流程执行中可能会遇到哪些问题?

- 如何进行SEO查询优化?有哪些工具可以使用?

- SEO优化外包服务值得信赖吗?外包中应注意什么?

- 热门tag

- 标签列表