搜索引擎Spider的工作运行原理

![]() 游客

2023-10-15 12:29:01

109

游客

2023-10-15 12:29:01

109

搜索引擎Spider的工作运行原理

随着互联网的普及,搜索引擎成为了人们获取信息的主要途径。而搜索引擎的核心部分就是Spider,它负责搜索和索引互联网上的所有内容。了解Spider的工作原理对于我们理解搜索引擎的工作过程至关重要。

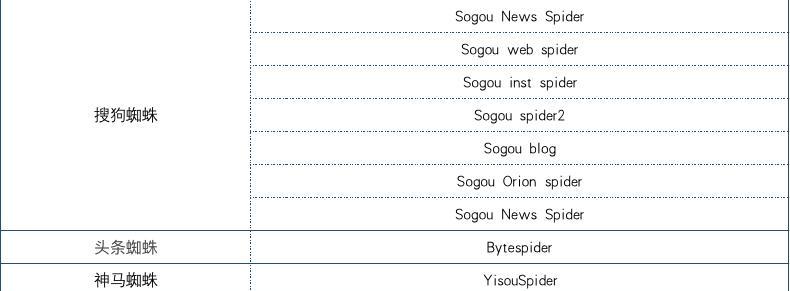

一、Spider的定义和作用

Spider是一种自动程序,也叫网络爬虫或蜘蛛,它能够自动地在互联网上遍历网页并获取其中的数据信息。其主要作用是通过收集互联网上的内容来建立搜索引擎的索引数据库,以便于用户在搜索时能够快速找到所需信息。

二、Spider的工作流程

Spider的工作流程主要包括发现、抓取、解析和索引四个阶段。具体来说,当Spider启动后,它会首先通过特定算法找到互联网上存在的新网页,并将其加入到待抓取队列中;按照一定频率,从待抓取队列中取出待抓取的网页,将其下载到本地并解析其中的HTML代码,以便于提取有用信息;将提取出来的信息存储到索引数据库中。

三、Spider的抓取策略

Spider抓取网页的策略主要有两种:广度优先和深度优先。广度优先策略是按照距离种子URL远近的顺序来抓取网页。深度优先策略则是先尽可能深地抓取一个网站的所有页面,再向下一个网站移动。在实际应用中,一般采用混合策略来平衡抓取效率和资源利用率。

四、Spider的封锁和反爬措施

为了避免Spider过度消耗服务器资源和影响正常用户的访问,许多网站都采取了一些封锁措施。比如,robots.txt文件可以告诉Spider哪些页面是不允许抓取的;IP限制可以防止同一IP过于频繁地访问某个网站;验证码可以防止自动程序进行恶意操作等。反爬措施则是指一些技术手段来识别和过滤自动程序的访问。

五、Spider的性能优化

Spider的性能优化可以从多个方面入手。可以通过增加抓取节点来提高并发性能;可以通过缓存机制和去重算法来减少重复抓取和提高效率;还可以通过不同的分布式技术和任务调度算法来实现性能优化。

六、Spider的应用场景

Spider广泛应用于搜索引擎、数据挖掘、信息监测等领域。在搜索引擎中,Spider是建立索引数据库的关键步骤;在数据挖掘中,Spider能够收集大量数据进行分析和挖掘;在信息监测中,Spider可以定期收集与特定关键字相关的信息。

七、Spider面临的挑战

随着互联网规模的不断扩大和复杂性的增加,Spider面临着越来越多的挑战。其中包括:反爬机制不断升级、抓取网页数量巨大、抓取内容质量难以保证等。如何应对这些挑战是未来Spider发展的重要方向之一。

八、结语

搜索引擎Spider是搜索引擎运行的重要组成部分,它能够自动地收集互联网上的所有内容,并建立起搜索引擎的索引数据库。通过了解其工作原理和优化技术,我们可以更好地理解搜索引擎,并深入思考如何进一步提升其效率和性能。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 3561739510@qq.com 举报,一经查实,本站将立刻删除。

转载请注明来自九九seo,本文标题:《搜索引擎Spider的工作运行原理》

标签:

- 搜索

- 最新文章

- 热门文章

-

- 网站设计网站哪个好?如何评估其设计质量?

- 百度网站优化排名如何提升?有效策略是什么?

- 搜索引擎优化SEO是什么意思?

- 百度关键词SEO如何优化?提升搜索排名的技巧

- 北京SEO公司哪家靠谱?如何选择专业的SEO服务?

- 昆山SEO优化的常见问题有哪些?

- 搜索引擎优化SEO的最新趋势是什么?

- SEM分析是什么?它如何帮助提升在线广告效果?

- 网站排名优化的原理是什么?如何通过基础知识进行优化?

- 长尾关键词是什么意思?如何利用长尾关键词提升SEO效果?

- 网站优化方案怎么制定?常见问题有哪些解决方法?

- 龙口网站制作流程是怎样的?

- 南县网站建设的费用是多少?南县网站建设需要多长时间?

- SEO优化的核心是什么?如何有效提升网站排名?

- 企业SEO优化排名要怎样提升?提升策略和常见问题解答?

- 如何管理SEO优化项目?项目管理中常见的问题是什么?

- 什么叫网站优化?网站优化的好处是什么?

- 上海网站开发中如何保证用户体验?

- 网站建设深圳有哪些优势?如何选择深圳网站建设服务?

- 网络营销是做什么的?如何进行有效的网络营销?

- 热门tag

- 标签列表