网站URL的稳定性对权重的影响(如何提高网站的稳定性来提升权重)

![]() 游客

2024-03-16 14:56:01

53

游客

2024-03-16 14:56:01

53

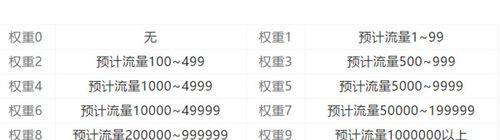

网站的权重直接关系到其能否在众多网站中脱颖而出,在如今日益竞争的互联网时代。保持网站URL的稳定性是提升网站权重的重要措施、而网站权重的高低很大程度上取决于其URL的稳定性。

合理选择域名

合理选择域名是确保URL稳定的首要条件。符合行业特点,易于传播以及有一定的SEO价值,好的域名应该简短易记。增加用户粘性、并且对提高搜索引擎排名也有一定作用、合理选择域名可以帮助用户快速记忆和找到网站。

规范网站URL结构

同时也方便用户了解页面所呈现的内容,规范网站URL结构可以让搜索引擎更容易理解页面内容。从而能够提高搜索引擎爬虫的抓取效率,良好的URL结构应该具备明确的层级关系,包含关键词和不包含无意义的字符等特点,简洁易懂、提高权重。

避免频繁修改URL

因为这会导致搜索引擎无法准确识别页面的内容变化,频繁修改URL会影响搜索引擎对网站权重的评估。将旧URL转移到新URL上、建议使用301重定向技术,如果确实需要修改URL,以保持页面的权重和排名。

使用HTTPS协议

并且能够提高搜索引擎对网站的信任度,使用HTTPS协议可以保证网站数据传输的安全性和可靠性。从而提高网站的稳定性和权重,建议网站尽可能采用HTTPS协议来加密数据。

避免使用动态URL

而这些参数和字符串对搜索引擎来说是无意义的,动态URL含有大量参数和随机字符串。静态URL更加稳定且易于理解、因此建议在设计网站时尽可能避免使用动态URL,相比之下。

避免死链和404页面

并且会导致搜索引擎爬虫无法访问页面,死链和404页面会影响用户体验。从而保证网站的稳定性和权重,并及时修复或删除这些页面,在设计网站时需要注意检查死链和404页面。

设置正确的robots.txt文件

减少爬取压力并节省资源,txt文件可以防止搜索引擎爬虫访问不必要的页面,正确设置robots。提高网站权重,同时,正确设置robots,txt文件可以帮助搜索引擎更好地理解页面内容。

及时更新sitemap.xml文件

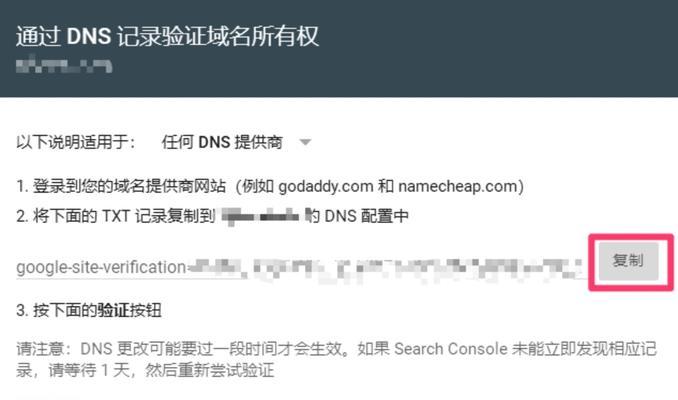

xml文件包含了网站的所有页面链接信息、可以帮助搜索引擎更好地了解和抓取页面内容、sitemap。并将其提交给搜索引擎以提高权重、建议及时更新sitemap,xml文件。

检查死链和404页面,xml文件,使用HTTPS协议,要实现这一点就需要合理选择域名,保持网站URL稳定是提高网站权重的关键措施之一,避免使用动态URL、txt文件以及及时更新sitemap,避免频繁修改URL,规范URL结构,设置正确的robots。只有在保持URL稳定的基础上才能更好地提高网站权重。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 3561739510@qq.com 举报,一经查实,本站将立刻删除。

转载请注明来自九九seo,本文标题:《网站URL的稳定性对权重的影响(如何提高网站的稳定性来提升权重)》

标签:网站

- 搜索

- 最新文章

- 热门文章

-

- 抖音直播引流推广大全(从零开始)

- 2024年抖音双11狂欢夜,玩法全解析(15个新鲜玩法)

- 如何学习SEO优化技能(从入门到精通)

- 如何获得优质的网站外链(提升玉溪SEO排名必须要做的事情)

- 如何通过域名优化提升SEO流量?-以成功吸引流量为主题

- 遇到SEO优化瓶颈怎么办?——15条实用建议

- 域名解析对SEO优化的影响(如何正确解析域名以提高网站排名)

- 掌握这七个SEO技巧,让您的网站获得更多流量(从研究到内部链接)

- 重复锚文本对网站优化的影响(探析多个重复锚文本在网页中的应用及其对SEO的影响)

- 站长常遇到的优化问题(如何解决常见的优化问题)

- 长尾挖掘及其作用详解(如何利用长尾提升网站SEO效果)

- 掌握有效的SEO优化策略,让你的网站在搜索引擎中脱颖而出(从优化到网站结构优化)

- SEO排名和普通SEO优化的区别——打造更高效的网络营销

- 域名和空间对搜索引擎优化的影响(从域名选择到空间配置)

- 域名和空间对于网站优化的重要性(从SEO角度分析)

- 长尾的重要性(优化网站排名的必备策略)

- 掌握SEO优化策略,让您的网站更具吸引力(八个有效的SEO优化策略)

- 抖音视频计划必须是视频吗(解析抖音视频计划的类型及要求)

- 长尾与核心的优劣分析(如何找到长尾和核心的组合提升网站流量)

- 掌握网站优化的5种技巧(提高网站排名)

- 热门tag

- 标签列表